【直播回看】IT系统为什么需要可观测性

“云原生可观测性分享会”第一期内容《IT系统为什么需要可观测性》由云杉网络CEO亓亚烜演讲,内容包括可观测性的五个方面:1、从为什么需要可观测性?2、如何理解可观测性?3、如何评估可观测性?4、如何构建可观测性?5、如何使用可观测性?来进行阐述。

同时分享了10个行业案例,帮助大家进一步的了解可观测性。当然,也总结了许多可观测性的技术价值和应用实践,希望能够帮助大家可以合理的去选择可观测性技术。【点击链接】可前往直播回看地址。下文为直播实录,接下来请大家开启沉浸式阅读模式吧。

我分享的议题包括可观测性的五个方面。我会直入主题,先把结论告诉大家。

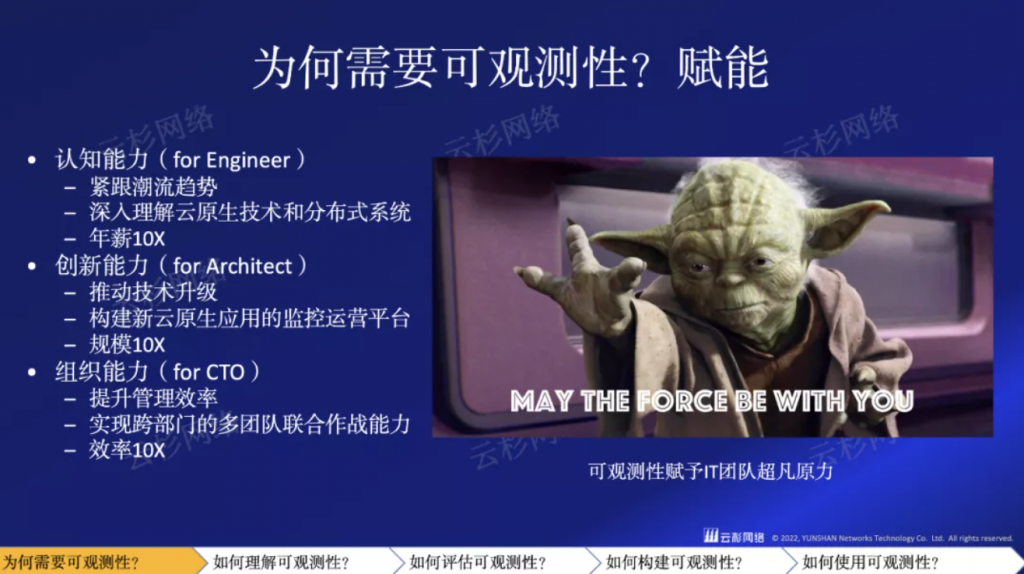

首先,为什么需要可观测性?答案是”赋能“。可观测性的根本价值,是给IT人员赋能。让工程师、架构师、乃至CTO、CIO能够随技术进步而进步。关于如何理解可观测性,我总结了几位业界大神的定义,他们的观点非常有参考价值。同时我也根据自己的分析和理解,提出了独立的见解,可观测性即白盒监控。如果不能评估他,你就不能改进他。可观测性的评估至为重要,基于白盒监控的理解,我给出了三类可观测性评估判据,以此帮助大家选择合理的可观测性技术。关于如何构建可观测性,无外乎三种方式:SaaS服务、开源开发、集成产品,这三种方式对大多数企业都非常重要,SaaS满足快速体验,开源满足业务需求,集成满足行业合规。最后,关于如何使用可观测性,我会分享多个行业的十多个实战用例。着重讲智能汽车和股份制银行两个用例,并简要分享十个其他行业案例,以此增强大家对可观测性的认知。

01 | 为什么需要可观测性?

02 | 如何理解可观测性?

Charity Majors是我非常尊重的一位创始人,她是连续创业者,也在Facebook工作过,近几年创立了Honeycomb公司,专注可观测性。她提出了一个非常独到的看法,即可观测性是用来解释“unknown-unknown“问题的,这个说法听起来似乎有点儿玄而又玄的感觉。

我跟大家解读下:unknown-unknown可以简单理解为探索未知问题。

软件工程中,有一套完整的debug工具,帮助开发人员发现软件中的未知问题。分布式系统监控中,可观测性扮演了类似debug工具的角色,通过交互式的追踪,定位未知问题。这里请大家注意,探索未知的说法,其实是Charity Majors借用了软件工程的理论来做可观测性。这样的思路,跟Google SRE的思路完全一致。在Google SRE book的第十二章中,明确说到了,可观测性的目的就是:快速排障。由此可见,软件工程是可观测性绕不过去的门槛。要想唤醒大家对软件工程的记忆,不妨重读下《人月神话》,必然会有新的体会。

比如新冠核酸检测:外部输出是被棉签捅着的东西。,内部状态是肺部是否被冠状病毒感染,有限时间是3~8个小时。如果不是外部输出,那就意味着需要抽血或者开刀;如果不是内部状态,那就无法进行分诊治疗;如果不是有限时间,那要么疫情泛滥,要么没法出行。

理解了这三个重点在防疫中的含义,下面就可以讲讲他们在IT系统中的解读。

现代控制理论,用状态空间来描述系统,通过可观测性和可控性解决复杂系统的控制问题。借用控制理论中可观测性理论,引出我对IT系统可观测性的认知。首先,状态空间代表白盒监控,即对系统内部状态要有清晰的理解,否则难以实现复杂应用的诊断。其次,外部输出意味着对系统应是零侵扰的,尤其是对业务是零侵扰的,否则干扰系统运行,无法实现控制目的。再次,内部状态一定是多维度的,对IT系统而言,就是我们常说的全栈,包括应用、系统、网络及各类中间件。最后,有限时间意味着实时性,从开发测试角度而言,调试速度应该是分钟级的,从生产保障而言,故障响应速度至少也是分钟级的。因此,要支持分钟级的工作流,可观测性平台的响应速度必须是秒级的。

基于上述分析,我也提出自己对可观测性的理解。简单而言,可观测性就是为复杂IT系统寻求白盒监控能力。IT系统的可观测性应具备零侵扰、多维度、实时性等关键特性。以上便是我对可观测性的理解。如有不准确的地方,希望与大家讨论学习。

要做真正的技术创新,必须有独立的观点。舶来品虽好,但难得其真谛。我希望国内做可观测性的朋友们,能够多多交流,迸发出更多更深入的理解。后面,我将基于上述理解,进一步阐明可观测性的技术和价值。

03 | 如何评估可观测性?

可观测性,必须要解决以下问题:

- 在数百个服务中发现瓶颈:提供非采样,秒级精度,提供HTTP/DNS/GRPC等性能指标数据

- 在数千个访问中追踪应用:提供应用层Trace追踪数据,网络层Flow追踪数据

- 在数万个容器中定位根因:提供全栈(API、主机、基础设施)端到端指标数据、日志数据

关于零侵扰判据:

关于多维度判据:

关于实时性判据:

再回到原力的类比,如果没有零侵扰,可观测性平台,也就是原力收集平台,无法被大家接受。如果没有多维度,原力无法关联,自然失去了其意义。如果没有实时性,原力无法有效释放,被大家掌控。人的感知时间是秒级别的,因此实时性必须做到秒级。

有了上述判据,就可以定量评估可观测性技术了。

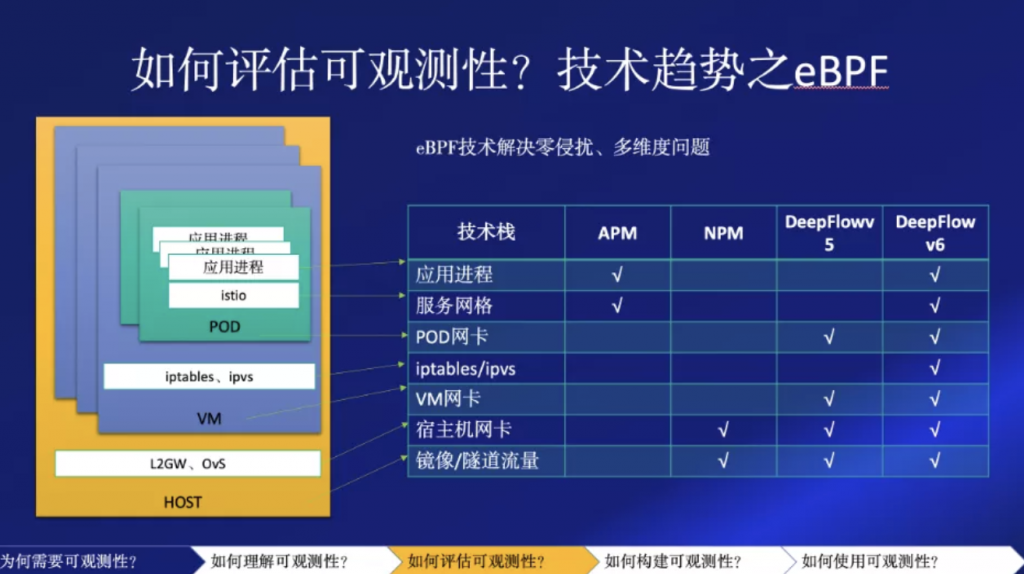

为了说明可观测性的技术评估,我这里依据自家产品,聚焦到两个核心技术趋势之上:eBPF和OLAP。eBPF解决了零侵扰,以及部分多维度问题。

如上图所示,左图中是一个接近全栈的多维度监控对象,其实就是一台服务器。可以看出,自下而上有,主机HOST系统,HOST的网络协议栈,虚机VM系统,虚机网络协议栈,容器POD,进程容器、Sidecar容器、应用进程等等。

传统APM,通过“打桩”,也就是插码,或者java agent的方式,能够对应用进程进行监控,即使扩展,也只能监控到部分sidecar。传统NPM,通过对设备的分光镜像流量,可以监控主机出入的流量,扩展后可以监控主机上虚拟交换机流量。

云杉DeepFlow v5.0 产品,在NPM基础上,利用classic BPF技术,通过host的用户态(零侵扰)监控到主机及虚机的系统和网卡流量。DeepFlow v6.0 产品,利用eBPF技术,进一步在零侵扰的前提下获取了应用和sidecar的信息,扩展了多维度的能力。做分析,离不开OLAP。可观测性的工程师,自然就是数据分析的工程师,OLAP能力不可缺失。过去三年时间,云杉DeepFlow产品中的关键数据组件,经历了两次重要的升级。2018年使用ES作为主要引擎,读写速度无法满足实时性要求,只能为数百台规模的业务集群实施可观测性。2020年初,DeepFlow v5.5发布,融入了深度优化的InfluxDB作为Metrics引擎,使平台性能提升10倍,可以解决数千台服务器集群的可观测性。2021年12月,DeepFlow v6.0的第一个版本发布,进一步融入了深度优化的ClickHouse作为观测数据的OLAP,读写性能再提升10倍,满足金融及互联网客户的数万规模的集群部署。

如果说摩尔定律是芯片演进的金科玉律,每18个月芯片效能增长2x。那么云时代的可观测性也不难预测:即每18个月观测数据读写速率增长10x。关于可观测性的概念和技术,讨论到此为止。

然而,纸上得来终觉浅。可观测性实战要真正落地,大家又面临哪些问题呢?既然可观测性是一种原力,而原力的掌控能力是一种增长的过程,那么我这里就借亚马逊的飞轮模型,来说明如何增长可观测性。

增长的第一步是理解和体验,体验可观测性的最佳方式当属各类SaaS服务,这些可观测性的SaaS服务可以让大家快速理解可观测性的价值。

增长的第二步是加速业务创新,也就是要满足业务部门的快速发展需求。开源是技术团队应对快速创新的最佳路径。因此,如何用开源技术构建可观测性平台是增长飞轮的第二步。

增长的第三步是满足生产需求,创新一旦完成,就要面临合规性、稳定性、安全性等一系列挑战,集成能力之于可观测性,就是赋能本身,让业务团队、基础设施团队、安全团队都能有效运转起来。

由于技术的不断进步,可观测性的飞轮将往复运行。K8S的体验之后,是Serverless,Prometheus之后是Skywalking,APM的作战半径不到20%,全链路成为永远的梦想?可观测性的增长飞轮,将引领大家解决上述问题。

04 | 如何构建可观测性?

相比而言,ARMS提供的是一站式服务,而SLS则给予了更多的自由度。国内的腾讯云、华为云等,也都提供了可观测性服务。如果是AWS、Azure的客户,那么可以直接使用Datadog,这个500亿美金市值的公司,可以看做是可观测性的领军企业,而且主要以提供SaaS服务为主。

国内的第三方提供商,目前看到的有观测云、乘云等,云杉也提供名为DeepFlow Cloud的SaaS产品,方便大家体验。

这个时代,整个IT系统都是构建在开源之上的,可观测性也不例外。依托开源技术构建可观测性平台,是快速技术创新的必由之路。

如图所示,自底向上构建基于开源的可观测性平台,可供选择的开源组件非常丰富。采集层,要实现零侵扰采集,可以采用K8S的daemonset采集器,java agent,普罗米修斯的部分exporter等等。

采集层要注意的是,云原生体系下,监控数据要遵循开放标准,这样整套系统框架才能不断演进,扩展。采集层的开放标准主要是statsd和opentelemetry,尤其是opentelemetry,大有一统江湖的趋势。采集层之上是数据层,之所以是数据而不是存储层,是因为要满足实时性要求,读存写必须分离。本质上数据层就是一个实时数仓,要针对应用场景,进行深度的读存写优化。实时数仓方面对技术要求较高,可以跟有经验的团队或厂商一起开发。数据层之上,是展示层。指标、追踪、日志、告警,分别由grafana、skywalking、kibana、prometheus等常用组件支持。让这些开源项目支持更多种类的数据展示,同时为不同部门提供不同场景的APP、WEB、CLI、API,是可观测性平台团队的主要工作。

下面我们来看一个我们的客户,是如何改造Grafana,为微服务提供可观测性的。

客户的开发团队,要求对每一个微服务提供精细的指标监控,包括HTTP、DNS的RED指标,即用量、错误、时延指标,也同时要求TCP和网络层的各类指标,形成全栈链路监控能力。客户的业务团队还要求把每个微服务的全局调用关系实时展示出来,这些工作都是客户的平台团队基于Grafana二次开发完成的。

如图所示,虽然每一个展示的子视图,大多是Grafana自带的,但视图中的数据,都不是开源的telegraph可以直接获取到的。

事实上,客户在数据层与采集层与云杉团队合作,解决了上述数据的零侵扰采集和实时读存写问题,客户团队更多专注于Grafana的二次开发,快速满足业务需求。由此可见,开源项目并不是拿来就能用的,而是需要依据业务需求进行快速开发。如果把时间花在改进开源项目的性能上,那应该由专业团队来做,并依据开源协议为社区做出贡献。

第三种构建可观测性的方式就是集成,integration。集成听起来没有SaaS和开源性感,但我认为,集成的难度最大,因为集成的约束条件太多。这些约束条件包括,理解业务需求,提出合理预算,满足行业合规,推动部门合作等等。每一个地方出现问题,都会造成集成项目无法落地,或者无法创造价值,最终导致项目失败或难以持续发展。集成的问题非常复杂,我这里提出两种解决思路。

第一个思路是”数据即事实“,部门之间的协作应该建立在数据事实的基础之上,而不是个人主观的描述,避免责任推诿,促进团队协作。

思路好理解,但落地仍然不明确,下面我们举一个栗子来进一步说明集成的复杂性。这是某大行网络工程师给我们的发展规划。诸位听众中如果有网络工程师,可以对比下是否有这样的先进思路?

首先,集成的第一步是全栈流量采集能力,而这里考虑最多的是零侵扰特性。零侵扰被进一步划分为:稳定性、可用性、资源耗损、通用性、存储消耗、网络消耗等问题。每一个问题都需要严格的长期测试才能验证。

第二步是建立分布式系统的诊断能力。这里面考虑最多的是多维度分析能力。协议栈设计到了物理机、虚拟机、容器、业务码等,并且要求提供全栈链路追踪。另外要求能够被大数据平台和其他监控平台通过API集成。

第三步是对外服务能力。也就是之前所说的原力释放阶段。这里考虑最多的是场景和自服务。场景包括了全网监控、应用监控、客户监控、安全监控等,自服务则要求主要功能均通过用户自行完成。由于不同场景需要不同的数据支持,背后技术涉及到了实时数仓的建立和集成。

新一代的网络工程师,借助可观测性,实现了自我价值,并提升了团队间的协作能力。与之类似,系统团队、开发团队、SRE团队等,均可以通过集成方法构建可观测性平台,以提升团队的自身价值和协作能力。

05 | 如何使用可观测性?

由于客户端、服务端均没有(或无法)部署Skywalking监控、没有采集日志,开发人员不知道超时原因。这个问题经过一整天排查未有结论,严重影响业务上线进度。借助可观测性的全栈能力,SRE团队在15分钟内定位到了根因,即问题出自一个特定的Ingress Control的容器POD。反馈到开发人员后通过修复Nginx快速恢复了故障。

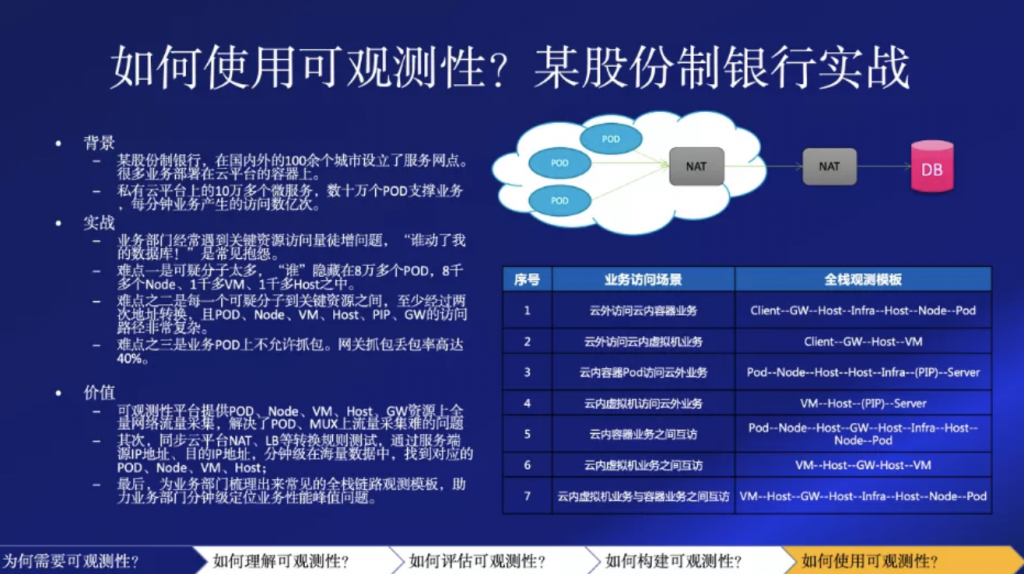

第二个用例来自某股份制银行,该行在国内外的100多个城市设立了服务网点。很多业务部署在云平台的容器上。该行私有云平台上运行着10万多个微服务,数十万个POD支撑业务,每分钟业务产生的访问数亿次。该行业务运维人员经常遇到关键资源访问量徒增问题,尤其是云上云下互访时,“谁动了我的数据库!”是常见抱怨。要追查出到底是谁动了关键资源,难点重重。

难点之一是可疑分子太多,可疑分子隐藏在8万多个POD,8千多个Node、1千多VM、1千多Host之中。难点之二是每个可疑分子到关键资源之间,至少经过两次地址转换,且POD、Node、VM、Host、PIP、GW的访问路径非常复杂。难点之三是业务POD上不允许抓包,网关GW上也难以抓包(网关抓包丢包率高达40%)。

上述问题通过可观测性就得到了良好解决。首先,可观测性平台提供POD、Node、VM、Host、GW资源上全量网络流量采集,解决了POD、MUX上流量采集难的问题其次,可观测性平台同步了云平台NAT、LB等转换规则,通过服务端源IP地址、目的IP地址,分钟级在海量数据中,找到对应的POD、Node、VM、Host;最后,可观测性平台为业务部门梳理出来常见的全栈链路观测模板,助力业务部门分钟级定位业务性能峰值问题。

第一个用例,是某银行在开发测试中遇到业务周期性抖动,持续一周无法上线。最终通过可观测性发现了底层路由器环路导致。

第四个用例,某运营商省公司在集团对应用的可用性考核中,年年全省垫底。最终通过可观测性,发现了LVS、nginx和某物理交换机之间的链路有丢包,彻底排除了困扰已久的问题。

第五个用例,某大型私有云客户,发现其关键业务中的SQL集群频繁主备切换,虽然业务没有中断,但风险极高。后经可观测性平台分析,发现是SQL切换仲裁在并发并不高的情况下就停止了服务,最终导致了不必要的切换。

第六个用例,某银行个人贷款业务突然访问变慢,在大家都怀疑是网关丢包的情况下,通过可观测性平台,定位到了DNS服务异常。而且,进一步发现不仅仅是该业务的可用区DNS异常,其他区域也有普遍现象,根本原因是DNS配置错误。

第八个用例,某省消防队,经常被省里通报,尤其是护网期间通报,必须排除通报的安全问题。由于全省消防内网复杂,而通报又只针对不到10个对外服务的IP,如何追查内部攻击源变得非常困难。通过可观测性平台,该省消防队实现了10分钟内应答通报的能力。

第九个用例,某大型容器云平台,按传统pcap分析方式运维,一次简单故障平均查找数千个数据包,耗费专家数小时的宝贵时间。通过可观测性平台,业务排障由抓包分析变为微服务RED指标监控和全栈链路追踪,排障效率从小时级变为分钟级。

第十个用例,某农商行,视频业务上云后访问量增长近10倍,经常出现业务访问慢问题,几次扩容都不能解决问题。后根据可观测性平台分析,发现是某个隐藏服务异常发送RST包导致,优化服务的队列和超时设置之后,业务恢复正常。

我这里先简单介绍10个用例,更多更精彩的用例分享,会由我们的同事、客户和合作伙伴在后面的直播中跟大家继续分享。

好了,总结一下今天介绍。

为什么需要可观测性,就是给大家”赋能“。让工程师、架构师、以及技术管理人员能够提升自我的认知能力、创新能力和组织能力。

如何理解可观测性,介绍了三种不同的视角:

- 三大支柱说,也就是three pillars,来自Peter Bourgon,背后是数据结构理论。

- 探索未知说,也就是unknown-unknown,来自Charity Majors,背后是软件工程理论。

- 白盒监控说,也就是white-box monitoring,是我根据控制理论中可观测性的定义推导出来的。

如何评估可观测性,主要三个方面,零侵扰、多维度、实时性。之前的介绍中也给出了详细的判据和背后的技术趋势。

至于如何构建可观测性,介绍了三种方法,SaaS用于体验、开源用于创新、集成用于合规。